(AI的两种路线)

侯世达在1995年预言,

(在人工智能)基于逻辑的形式方法是死路一条。一一侯世达1995

(AI)The logic-based formal approach is a dead end.一一Hofstadter1995

10年后,预言成真了,20年后的今天,侯世达预言的Analogy Intelligence已经随着Alpha Go的出现,占有人工智能几乎全部的主要成果。

人工智能教父Hinton在BBVA获奖时说,AI的两种路线之争,是一场50年的战争。

(Hinton的战争宣言)

当然,最终以基于类比Analogy的路线胜利而告一段落。

1,发轫:神经网络是骗子

人工神经网络ANN,简称神经网络NN,是模仿大脑神经网络的结构而建立的一种人工智能模型,神经网络由大量的神经元联结进行计算,通过外部信息,改变其内部的结构,这是一种自适应过程,或者叫做学习过程。

神经网络最开始是由Warren S. McCulloch和Walter Pitts在1943年引入的,最初是用一种阀值的算法,创造一种神经网络的计算模型。

(图片来自chaipp0607)

不过这位McCulloch一开始就被当做骗子,Jack Cowan回忆说:

图灵确实跟McCulloch见过面,认为他是个骗子。如果你不了解McCulloch,你可能很容易地得到McCulloch是骗子的印象。

Turing actually met McCulloch at one time and thought he was a charlatan, but I think he simply underestimated McCulloch, in many ways. You could easily get the impression that McCulloch was a charlatan if you didn't know better. by Jack D. Cowan

当时由于缺乏计算资源,模型无法测试。直到1958年,Frank Rosenblatt创建了可以进行模式识别的感知器模型,感知器Perceptron,是那时候神经网络的代称,不过,现状仍然没有任何改变,当时连计算机都还在实验室呢,这些早期研究连测试环境都找不到。

2,冰封三十年:神经网络注定失败

大概在1959年,即感知器模型发明10年后,Marvin Minsky和Seymour Papert出版了一本书《Perceptrons》,分析了感知器(及其代表的单层神经网络)模型的局限。书中称,没有人能够训练它解决一个基本的异或XOR问题,所以,感知器模型注定失败。由于《Perceptrons》的巨大影响,几乎冰封神经网络研究30年。

后来有人总结当时神经网络的两个障碍。一是因为它局部无法有效的求导,二是因为当时人们都相信大脑类似于电脑一样,神经元类似于数码元件,输出是0和1。前一个是技术局限,后一个是观念问题。反向传播(使用链式求导法则反向传递误差数据)发明者Werbos后来回忆说:

1971年,我去找Marvin Minsky,说我有一个方法,可以解决神经网络的这些问题,我写成了论文。Minsky说我不想做描述这个新方法的论文的共同作者。Minsky本可以分享反向传播的荣誉,但他说,我不想做这个,它会把我从殿堂上赶出来,我会失去MIT的地位。我不能冒这么大的风险,因为每个人都认为神经元是输出0/1的,很多人现在还是这么认为的。 by Paul J. Werbos

(反向传播,多层神经网络的基础算法)

3,分裂:神经网络不靠谱

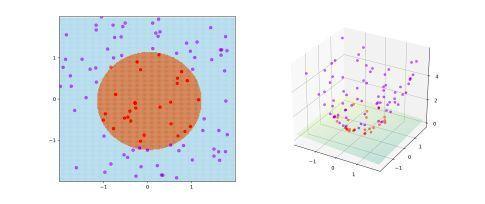

1993年左右,Vapnik等发明了一种核技巧kernel trick,可以将一般类型关系的数据实例直接映射到高维,从而很容易的找到分离平面,然后再回到低维。

(训练点的三维映射)

当时比较有效的核方法是支持向量机SVM。SVM的发明者Vapnik把搞神经网络的人骂惨了,说搞人工智能的有两种人,一种是靠谱的,一种就是搞神经网络的。

直到2006年,神经网络通过深度学习的模型(多层神经网络模型),终于出了成果。不过Vapnik仍然坚持说深度学习是使用暴力Brute Force,没有理论指导,是恶魔的行事方式,与智能无关。

不过后来Bengio谈到,Vapnik的SVM本质上使用一种叫做Smooth的先在策略巧妙越过了机器学习中的局部最小值问题,所以,2000年左右效果比神经网络要好很多。而神经网络训练复杂,一直没有找到好的策略,统计派一直炮轰神经网络的局部最小值问题,直到后来使用了梯度下降的方法。当然,Bengio仍然没有给出神经网络的形式化方法。

4,责难:神经网络是炼金术

2006年,Hinton的两个学生,实现了语音识别最近30年来最大的突破。2009年,图像识别突破。2012年,谷歌引入了Hinton作为谷歌大脑的科学家,然后一系列神经网络的技术实用化,包含2015年Youtube的自动字幕、2016年的Google Translate、2017年的Alpha Go等等。

不过,即便如此,对神经网络的责难一直没有停止过。来源于不止是人工智能内部,还包含数学、统计学、神经生物学、认知科学。其中最有趣的说法就是,神经网络是炼金术。

(机器学习是炼金术ML is alchemy,Ali Rahimi NIPS 2017,Ben Recht 2017)

后来成为那个知名的梗,效果是有了,但没有人都知道是怎么做到的。

5,两种路线:神经网络是荒谬的幻想

Hinton在2017年BBVA获奖演讲中谈到神经网络曲折的发展历程,

50多年来,人工智能的两个愿景之间发生了争执,受逻辑启发的经典观点认为,智能是关于推理的,而且为了使系统能够在现实世界中合理的推理,我们需要手工输入大量事实,并且还应该在应用它们时,输入大量的推理和启发式规则。竞争对手的观点是我们应该关注生物学,并尝试模仿大脑的神经网络,特别是我们应该关注这些网络如何从经验中学习,以便我们就不必手动指定所有知识。神经网络方法被大多数人工智能研究者认为是一种荒谬的幻想。一一Hinton

Over 50 years there was a battle between two visions of artificial intelligence, the classical view inspired by logic was that intelligence was all about reasoning and that to make systems that reason sensibly in the real world we would need to enter a very large number of facts by hand, and also a large number of rules for when they should be applied. The rival view was that we should try to mimic the neural networks of the brain. In particular we should focus on how these networks learned from experience so that we would not have to specify all the knowledge by hand. The neural network approach was regarded as a ridiculous fantasy by most people in AI. by Hinton

这云淡风轻的描述中,我们其实完全看不到这场“战争”的真实情况,《人工智能教父Hinton怼战记》一文简要介绍其中三种对神经网络有启发性的讨论,但也没有还原当时的实际状况。这不是苏士侃所著的《黑洞战争》所描述那种小儿科的赌斗,而真是很惨烈的“战争”。

面对“战争”,我们不禁要问,为什么?这不就是一种非主流的技术经过几十年努力成为主流吗,为什么还会有一场“战争”呢?

因为这不是表面看来解决某个具体问题,而是涉及到更深层次的范式冲突。它是逻辑和类比的之间的路线冲突,而这种新的人工智能AI,可以称为“Analogy Intelligence”。

6,范式冲突

“范式冲突”是张恩文谈到人工智能的两种路线之争时的随言。不过它涉及到科学的构建、智能的意义。

科学Science一词来源于拉丁文scientia,意为知识,总的来说,科学就是我们认识世界的知识的集合。到了现代,经过几千年的努力,我们构建了一整个蔚为壮观的知识的大厦,它建立在形式科学Formal Science的基石之上,包含数学、逻辑、理论计算机科学。没有这个基石,我们就无法用一种精确的方式认识和描述世界,建立生物学、物理学等自然科学;我们也无法以同样的方式认识和描述社会,建立经济学、心理学、社会学。

形式科学,虽然是有局限的,但目前我们还没有有效替代它的方法。证明了形式科学有其局限的哥德尔,就把“每件事都有意义”(哥德尔认为它严格相似于每件事情之后都有原因),作为他最重要的观点。即便我们用科学否定了实在reality(爱因斯坦之后时间和空间就不再是自然律了),我们仍然相信,我们的科学大厦如此坚实,至少要比reality坚实。哪怕仍然还有未知存在,但“我们终将知道,我们必将知道”(Hilbert)。

然而,动摇还是发生了。

(图灵:

来自未知世界的消息 1954

III 宇宙是创造之光锥的内景

IV 科学是微分方程,宗教是边界条件

Arthur Stanley

)

图灵说,我们并不理解我们创造出来的东西。哪怕通过神经网络得出了我们预期的结果,我们仍不知道它是如何工作的,我们只是知道初始条件、参数,但我们并不能用一种形式化科学,我们能理解的形式将它表示出来。

过去,虽然经过很长的时间(比如300年),我们仍然找到了一组公式,如牛顿三定律,对过去行星运动数据进行表示,而且通过它预测其未来运行。现在,我们可以预测某种数据模型,却不再能写出公式和其推导过程,即形式化表示。Bengio的框架是,“共享现实输入-表示状态-意识状态-语言(符号)”,每一层次增加的抽象,即对应更为复杂的计算过程。这种过程可以被重现,却不可简化为日常交流的有限个可记忆或可记录的公式。它甚至对日常的不借助外部辅助设备的我们而言,是不可理解的。

在一个人工智能panel上,

主持人:我们按照这种方法制造的AI,有一个副作用,它是不能逆向工程分解的。我们将在这种技术上面全速前进,以产生出最具智能、最大容量、最快速、以及(或许是)所有这些,那么是否我们就面临着一个问题:为了试图去理解我们建造的东西,你就得知道他们内部到底是如何工作的?

Hinton:我认为我们不会完全理解这些家伙是如何思考的,这也是图灵所相信的。实际上,图灵相信我们不是图灵机,我们是神经网络。他做了一些关于神经网络的早期工作,我不太记得他在某个地方说过,我们不会知道他们是怎么工作的。

Sutton:好啦,我们也不理解我们本身是怎么工作的。

(“我们可以建模特朗普,但我们不能建模希拉里”出自同一Panel)

甚至,神经网络并不是如同我们预期的那样,基于逻辑(或逻辑上不可能),而是基于类比analogy。所以,它与传统的科学进路有着根本冲突,它是反直觉的,这也是它一直不被重视,一直不被理智采纳,一直被压制,一直被围攻的原因。

但也许,我们应该回过头来,重新认识我们自己。我们自身并不是基于逻辑的动物,我们只不过是依靠类比工作的设备。

我们不过是使用类比工作的设备,它比说我们依靠推理工作,更为根本。一一Hinton

I just say we are devices that work by using analogies and that's much more basic to how we work than reasoning。

by Hinton

7,结语:科学将要消亡,而技术永生

我们现在称之为科学的这套东西,也许,在不久的将来会直接失效,直接消亡。系统化的理论,还是工具主义。是我们自己的局限而已。

而技术最终会独立于科学更加飞速的发展,我们并不一定需要有一种科学来理解技术的状况。也许仍然会诞生一种技术的解释,用我们局限的认知,去理解技术的发展,我们仍然可以称之为科学。

不过,它会类似于魔法而已。